Denkende Maschinen

Denkende Maschinen

- Autorinnen / Autoren:

- Jens Tiemann

- Zuletzt bearbeitet:

- Jul 2016

- Titel:

- Denkende Maschinen

- Trendthema Nummer:

- 34

- Herausgeber:

- Kompetenzzentrum Öffentliche IT

- Titel der Gesamtausgabe

- ÖFIT-Trendschau: Öffentliche Informationstechnologie in der digitalisierten Gesellschaft

- Erscheinungsort:

- Berlin

- Autorinnen und Autoren der Gesamtausgabe:

- Mike Weber, Stephan Gauch, Faruch Amini, Tristan Kaiser, Jens Tiemann, Carsten Schmoll, Lutz Henckel, Gabriele Goldacker, Petra Hoepner, Nadja Menz, Maximilian Schmidt, Michael Stemmer, Florian Weigand, Christian Welzel, Jonas Pattberg, Nicole Opiela, Florian Friederici, Jan Gottschick, Jan Dennis Gumz, Fabian Manzke, Rudolf Roth, Dorian Grosch, Maximilian Gahntz, Hannes Wünsche, Simon Sebastian Hunt, Fabian Kirstein, Dunja Nofal, Basanta Thapa, Hüseyin Ugur Sagkal, Dorian Wachsmann, Michael Rothe, Oliver Schmidt, Jens Fromm

- URL:

- https://www.oeffentliche-it.de/-/denkende-maschinen

- ISBN:

- 978-3-9816025-2-4

- Lizenz:

- Dieses Werk ist lizenziert unter einer Creative Commons Namensnennung 3.0 Deutschland Lizenz (CC BY 3.0 DE) http://creativecommons.org/licenses/by/3.0 de/legalcode. Bedingung für die Nutzung des Werkes ist die Angabe der Namen der Autoren und Herausgeber.

Künstliche Intelligenz polarisiert wie kaum ein anderes Thema der Digitalisierung. Seit Jahrzehnten sollen »schon bald« nur schwer durchschaubare Maschinen den Menschen in seiner bislang exklusiven Domäne des problemlösenden Denkens übertrumpfen. Kinofilme nutzen diesen Angriff auf das menschliche Selbstverständnis ebenso für spektakuläre Darstellungen wie Feuilletons für philosophische und kulturkritische Betrachtungen. Seit einiger Zeit gewinnt das Thema durch konkrete Anwendungen neuen Schwung. Mit welchen Mechanismen und Auswirkungen werden wir in Zukunft tatsächlich konfrontiert? Verstricken wir uns in einem unkontrollierbaren Geflecht von Informationen mit unabsehbaren Folgen? »Alexa, Siri, Google – was meint ihr?«

Der breite Durchbruch ist bisher ausgeblieben

Die Vision von denkenden Maschinen und künstlicher Intelligenz (KI) ist genauso alt wie die Computertechnik selbst. Immer wieder wurden schnelle, große Entwicklungssprünge versprochen. Bei allen beeindruckenden und technologisch wichtigen Einzelerfolgen – erinnert sei an Schachspiele und Quizshows – bleibt der Durchbruch in der Breite bisher aus. Derzeit sind wieder erstaunliche Fähigkeiten von Maschinen zu beobachten – etwa bei persönlichen Assistenten (siehe Mensch-Maschine-Interaktion oder bei der Bilderkennung (siehe Neuronale Netze). Dabei können die Systeme auf bislang ungeahnte Datenmengen zur Kalibrierung und zum maschinellen Lernen zurückgreifen. Stehen wir nun kurz vor einem fundamentalen Durchbruch im Bereich KI?

Die Schwierigkeiten bei der Bewertung fangen schon bei der unklaren Begriffsdefinition für Intelligenz an. Wenig erstaunlich also, wenn Branchenkenner kognitive Systeme durch den »Wow-Faktor« von klassischen unterscheiden. Ein solcher Überraschungseffekt lässt sich nur schwer fassen und verblasst schnell: Was gestern noch faszinierte, gilt heute schon als selbstverständlich. Zudem neigen Menschen dazu, Ereignissen Intentionen zuzuschreiben. Darunter haben nicht nur Haustiere zu leiden, sondern es erklärt auch den bemerkenswerten Erfolg so einfacher Programme wie etwa den des legendären Chatbot ELIZA aus dem Jahr 1966, dem mitunter auf seine allgemeinen Fragen sehr persönliche Informationen offenbart wurden. Zielführend ist die Beschreibung von kognitiven Systemen anhand von vier Eigenschaften, die – mehr oder weniger stark ausgeprägt – allesamt vorliegen müssen: Kontextualität (Verständnis für die reale und virtuelle Umgebung in einer Situation (siehe Sichere Fahrzeugkommunikation)), Adaptivität (Lernfähigkeit im veränderlichen Umfeld), Interaktivität (komfortable Interaktion mit Nutzern) und Iterativität (Dialogfähigkeit zum Präzisieren von Zielen und Problemen).

"Wissensaufbau" durch maschinelles Lernen

Die KI-Forschung verfolgt zwei grundsätzliche, sich idealiter befruchtende Linien: Einerseits ist das Ziel, mehr über die ungeklärten Vorgänge des menschlichen Denkens zu erfahren. Für diesen Ansatz steht etwa das Human Brain Project, das durch Erforschung und Nachbildung neuronaler Prozesse des Gehirns auf grundlegende als auch auf vermarktungsfähige Forschungsergebnisse zielt. Andererseits geht es um clevere Algorithmen, mit denen Computer Alltagsprobleme lösen können. Auch ohne Verständnis der Mechanismen menschlichen Denkens werden so nützliche Lösungen entwickelt. Mustererkennung mittels sogenannter neuronaler Netze oder die Erfassung von Semantik aufgrund statistischer Verfahren sind dafür Beispiele.

Den Unterschied zu klassischen, stärker determinierten Systemen machen Verfahren zum maschinellen Lernen aus: Damit können technische Systeme selbsttätig grundsätzliche Eigenschaften oder Muster erkennen und in der Folge auch auf bis dahin unbekannte Eingangsdaten und in einem breiten Einsatzbereich anwenden. Hierfür wird »Wissen« in Form des internen Zustands des Systems aufgebaut.

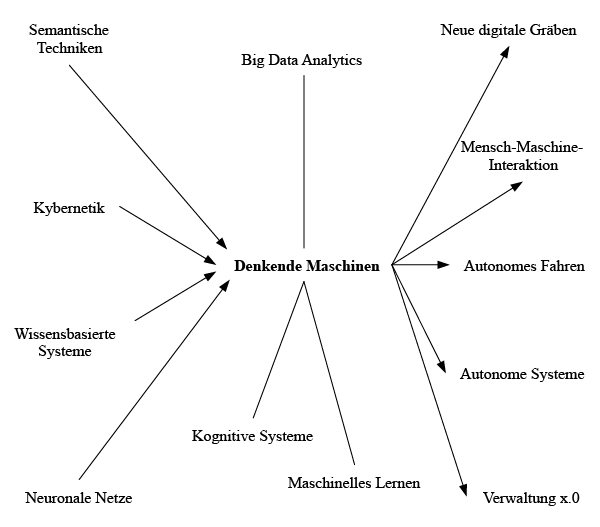

Begriffliche Verortung

Klassische Ansätze stoßen an ihre Grenzen

Zur vollständigen Beherrschbarkeit eines Systems gehört neben der Kenntnis der Eingangswerte auch der seines internen Zustandes. Anhand der Daten allein lassen sich die Ergebnisse nicht mehr reproduzieren. Kontrolle ist also nur bei kontinuierlichem Zugang zum System möglich. Die Folgen sind umfangreich: Das aus den Daten gewonnene Wissen verbleibt verdeckt im System. Auch bei festgelegten Rahmenbedingungen führt ein definierter Anfangszustand nicht zwangsläufig zu einem reproduzierbaren Endzustand. Vielmehr muss das Systemverhalten durch komplexe Teststellungen auf Basis typischer Einsatzsituationen bewertet und gegebenenfalls unter Zuhilfenahme statistischer Verfahren evaluiert werden. Die Möglichkeit zur vollständigen Systemabbildung bleibt dabei für Dokumentation und forensische Analysen wünschenswert, reicht für die Analyse eines sich ständig selbst anpassenden Systems aber nicht aus.

Klassische Ansätze zur Beherrschbarkeit stoßen bei kognitiven Systemen also schnell an ihre Grenzen. Umso wichtiger ist es, die grundsätzlichen Eigenschaften der verwendeten Algorithmen zu kennen. Ein Systembestandteil sollte eine Funktion für die Beschreibung der Herleitung seiner Ergebnisse sein (siehe Erklärbare KI). ). Zwar können solche Beschreibungen wiederum undurchsichtigen Algorithmen obliegen, sie sorgen jedoch für eine bessere Nachvollziehbarkeit der sonst als von einer Blackbox generiert empfundenen Endergebnisse. Gewissenhaft umgesetzt können solche Selbsterklärungsfunktionen nicht nur zu einem besseren Verständnis der Systeme, sondern auch zu einer sinnvollen Anpassung der Zielfunktionen führen. Im Idealfall werden so Zielvorstellungen und Zwischenschritte zu deren Erreichung transparenter und leichter gestaltbar. Gegenwärtige Ansätze, die Funktionsweise von KI-Algorithmen transparent zu machen, zielen noch eher auf die ex post Bewertung laufender Systeme.

Wer ist verantwortlich?

Mögliche Folgen für das Gemeinwesen hängen stark von der Art der kognitiven Systeme, der Betrachtungsebene und dem Anwendungsfeld ab. Die Übernahme trivialer Alltagsaufgaben dürfte bei hinreichender Systemintegrität unkritisch sein. Auch dürften einzelne komplexe Teilaufgaben wie Autonomes Fahren so gut zu bewältigen sein, dass sie insgesamt zu einer höheren (Verkehrs-)Sicherheit führen. Je individueller das Ergebnis, je folgenschwerer das Anwendungsfeld und je autonomer die kognitiven Systeme, desto problematischer werden Fragen nach Verantwortung und Haftung für die möglicherweise schwerwiegenden Folgen.

Eine zentrale Herausforderung betrifft die Überwindung bestehender und Schaffung neuer digitaler Gräben. Einerseits erlauben kognitive Systeme einen Grad an Nutzerfreundlichkeit (siehe Usability), der eine Teilhabe breiterer Bevölkerungsgruppen verspricht; andererseits können neue digitale Gräben entstehen, wenn die Teilhabe faktisch vertiefte technische und inhaltliche Kenntnisse erfordert. Entscheiden Computersysteme über menschliche Schicksale mit – etwa in der Bildung oder bei der Arbeitsplatzsuche – kann eine unangemessene Nutzung auch tragische Folgen haben.

Noch lösen Computer spezielle, klar umrissene Aufgaben mittels beträchtlicher Datenmengen und weiterhin wachsender Rechenleistung. Bereits damit erreichen sie beeindruckende Erfolge. Wenn sich dereinst die Verheißungen quasi-menschlich denkender Maschinen erfüllen, stellen sich wesentliche Fragen neu.

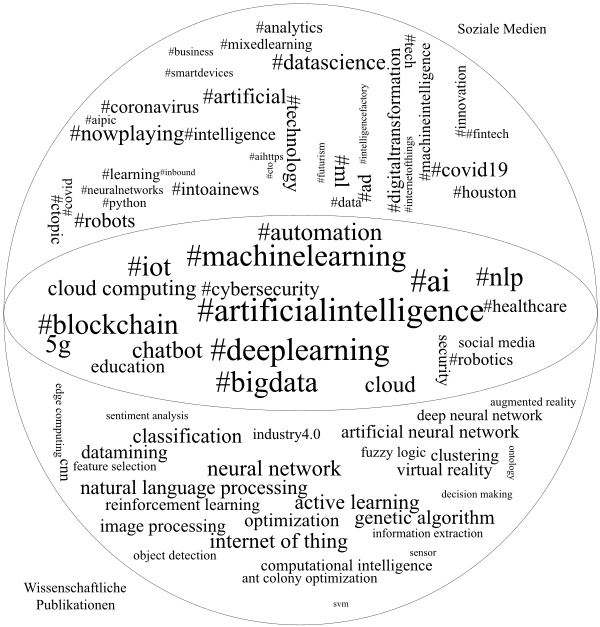

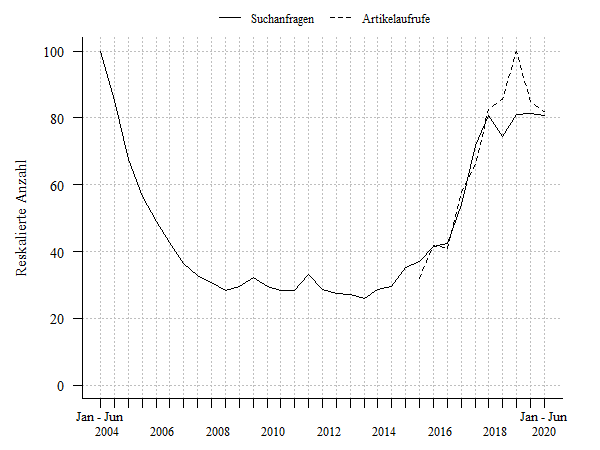

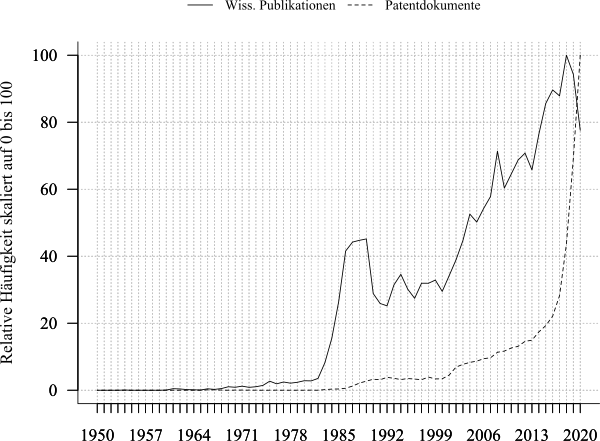

Themenkonjunkturen

Folgenabschätzung

Möglichkeiten

- Realisierbarkeit komplexer technischer Systeme

- Anpassungsfähigkeit von Maschinen an Mensch und Umwelt

- Schnittstellenerweiterung

- Verstärker menschlicher Kreativität

- Kontinuierliche, sich selbst verbessernde Entscheidungsunterstützung

- Transparente Entscheidungsabläufe

- Werkzeug für Wissensarbeit

- Übernahme von Routine-Wissensarbeiten

Wagnisse

- Beherrschung der Komplexität und Vernetzung natürlicher oder technischer Systeme

- Entwicklung von Konzepten und Werkzeugen zum Test komplexer Algorithmen

- Interpretation theoriefreier Analysen

- Entstehung neuer digitaler Gräben

- Verantwortung und Verantwortungszuschreibung bei negativen Folgen

- Umbrüche des Arbeitsmarktes

Handlungsräume

Forschungsförderung zu den Themen Testen und Selbsterklären

Um die Zuverlässigkeit und Korrektheit kognitiver Systeme zu testen, reichen Systemabbildungen nicht mehr aus. Ergänzend bedarf es komplexer Teststellungen und statistischer Analysen. Zugleich müssen kognitive Systeme ihre eigenen Ergebnisse nachvollziehbar begründen können. Hierzu bedarf es umfassender interdisziplinärer Forschung aus einer Gemeinwohlperspektive.

Neue Formen der Markt- und Sicherheitsregulierung

Die Eigenschaften kognitiver Systeme machen neue Regulierungsregime notwendig. Bestehende Fragen nach Rechten an Daten werden durch Fragen nach Rechten am gewonnenen Wissen verschärft. Gleiches gilt für die Gewährleistung der Sicherheit bei Entwicklung und Betrieb derartiger Systeme.

Anwendungen im öffentlichen Sektor

Kognitive Systeme bieten sowohl in der öffentlichen Leistungserstellung (siehe Verwaltung x.0) als auch zur Fundierung politischer Entscheidungen beträchtliche Potenziale. Diese zu nutzen und dabei neue Formen der Transparenz zu entwickeln, kann Effizienz und Effektivität zum Vorteil der Bürgerinnen und Bürger steigern.