Erklärbare KI: Vertrauen schaffen am Beispiel des persönlichen Inflationsrechners des Statistischen Bundesamts

Erklärbare KI: Vertrauen schaffen am Beispiel des persönlichen Inflationsrechners des Statistischen Bundesamts

Erklärbare KI: Vertrauen schaffen am Beispiel des persönlichen Inflationsrechners des Statistischen Bundesamts

Gastbeitrag von Dr. Maximilian Förster und Prof. Dr. Mathias Klier

Dr. Maximilian Förster ist Postdoktorand und Habilitand am Institut für Business Analytics an der Universität Ulm. Dort leitet er die Forschungsgruppe zu Erklärbarer Künstliche Intelligenz. Weitere Forschungsschwerpunkte sind Social Impact of Information Systems und Future Skills. Mit seiner Forschung möchte er zu einer Gesellschaft beitragen, in der Technologie für alle zugänglich und nützlich ist.

Prof. Dr. Mathias Klier hat die Péter-Horváth-Stiftungsprofessur für Betriebswirtschaftslehre mit dem Schwerpunkt betriebswirtschaftliches Informationsmanagement am Institut für Business Analytics der Universität Ulm inne. Seine Forschungsinteressen liegen insbesondere in den Bereichen Big Data Analytics, Datenqualität, (Erklärbare) Künstliche Intelligenz sowie Social Media und Social Impact of Information Systems.

Der Beitrag von Künstlicher Intelligenz (KI) zur Digitalisierung der öffentlichen Verwaltung könnte riesig sein – wenn die Technologie nicht so undurchsichtig wäre. In der öffentlichen Verwaltung ist Transparenz besonders wichtig, damit digitale Anwendungen das Vertrauen von Bürger:innen gewinnen. Ein Forschungsprojekt zeigt nun, wie die digitale Transformation der öffentlichen Verwaltung mithilfe von »Erklärbarer KI« vertrauenswürdig und bürger:innennah erfolgen kann.

KI kann die digitale Transformation ankurbeln

Die Erwartungen von Bürger:innen an die nachzuholende Digitalisierung in der öffentlichen Verwaltung sind hoch. Besonderes Potenzial für die digitale Transformation birgt KI. Datenbasierte Verfahren – wie KI-Verfahren – können sehr gute Ergebnisse liefern. Rasante Fortschritte in der Forschung sorgen für eine immer größere Vielfalt an Anwendungsmöglichkeiten. In der öffentlichen Verwaltung können KI-basierte Anwendungen Verwaltungsprozesse vereinfachen und beschleunigen, Bürger:innen neue Informationskanäle zur Verfügung stellen und Entscheidungs- und Planungsprozesse verbessern. Eine große Herausforderung besteht darin, solche digitalen Anwendungen bürger:innenzentriert zu gestalten. Tatsächlich zeigen Studien, dass für bestehende Anwendungen in der öffentlichen Verwaltung gute Praktiken fehlen, um das Vertrauen von Beschäftigten und Bürger:innen sicherzustellen.

Viele digitale Anwendungen haben ein Verständlichkeitsproblem

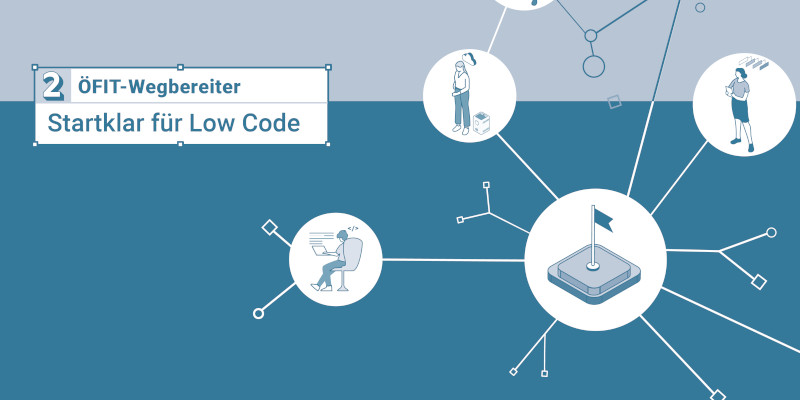

Mit dieser Herausforderung steht die öffentliche Verwaltung nicht allein da. Viele digitale Anwendungen – im öffentlichen Sektor wie in der Privatwirtschaft – haben ein Verständlichkeitsproblem. Dabei spielt keine Rolle, ob einer digitalen Anwendung hochkomplexe KI-Verfahren oder einfachere datenbasierte Verfahren zugrunde liegen. Entscheidend ist die Wahrnehmung der Nutzer:innen. Wenn Nutzer:innen nicht mehr nachvollziehen können, wie die Ergebnisse der datenbasierten Verfahren zustande kommen, ist die digitale Anwendung für sie eine »Black Box«. Bürger:innen haben dann keine Möglichkeit mehr, Rückfragen zu stellen oder Widerspruch einzulegen, wie dies in einem Gespräch mit einem menschlichen Gegenüber möglich wäre. Wie sollen Bürger:innen einer Anwendung vertrauen, die sie über ihre Entscheidungswege und -gründe im Dunkeln lässt? Stand heute fehlt es an konkreten Maßnahmen, um digitale Anwendungen in der öffentlichen Verwaltung transparent und nachvollziehbar zu machen.

Bürger:innenzentrierung durch »Erklärbare KI« verbessern

Die Nachvollziehbarkeit und Nutzer:innenzentrierung von digitalen Anwendungen zu steigern ist unter dem Begriff »Erklärbare KI« eine eigene Forschungsdisziplin geworden. Erklärbare KI (oft: XAI, vom Englischen »Explainable Artificial Intelligence«) beschreibt technische und methodische Ansätze, welche die Ergebnisse von datenbasierten Verfahren für Menschen verständlich machen. Es werden automatisiert Erklärungen erzeugt, welche die Entscheidungswege und -gründe eines datenbasierten Verfahrens für Nutzer:innen offenlegen.

Typischerweise werden Erklärungen durch Erklärmodule erzeugt, die ergänzend zu einem datenbasierten Verfahren entwickelt und installiert werden. Um eine Erklärung zu erzeugen, »beobachtet« das Erklärmodul das Verhalten eines datenbasierten Verfahrens. Oft sind Erklärmodule modell-agnostisch gestaltet, sodass sie für eine Vielzahl an existierenden datenbasierten Verfahren – seien es neuronale Netz oder einfache datenbasierte Verfahren – anwendbar sind.

Entwickler:innen von »Erklärbarer KI« legen Wert darauf, dass Darstellung, Umfang und Inhalt von Erklärungen auf den Kenntnisstand und die Bedürfnisse der Nutzer:innen einer konkreten Anwendung abgestimmt sind. Sonst verfehlen Erklärungen ihren Zweck. Zum Beispiel brauchen Bürger:innen, die digitale Behördendienste in Anspruch nehmen, andere Erklärungen als Manager:innen, die digitale Anwendungen zur Prognose von Unternehmenskennzahlen nutzen.

Das XAI-Studio – das gemeinsame Innovationslabor des Instituts für Business Analytics der Universität Ulm und des KI-Startups Inlinity – begleitet die öffentliche Verwaltung dabei, das Potenzial der Schlüsseltechnologie »Erklärbare KI« zur Entfaltung zu bringen. In einem gemeinsamen Leuchtturmprojekt hat das XAI-Studio mit dem Statistischen Bundesamt deren Applikation »persönlicher Inflationsrechner« um ein Erklärmodul erweitert und so die Bedürfnisse von Bürger:innen nach mehr Nachvollziehbarkeit der Auswirkungen von Inflation auf die eigene Lebensrealität adressiert.

Showcase: Der persönliche Inflationsrechner des Statistischen Bundesamts

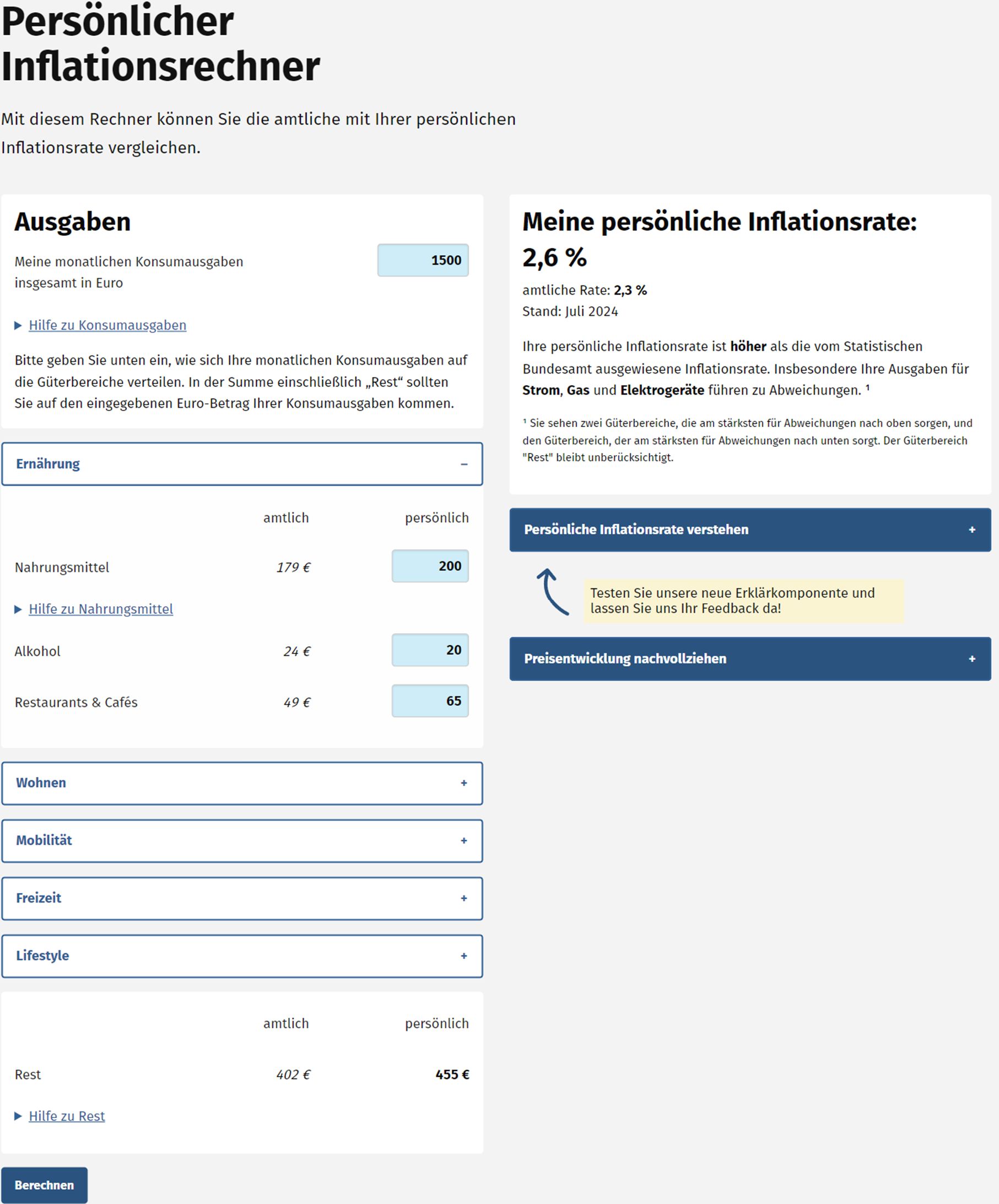

Das Statistische Bundesamt bietet auf seiner Website einen persönlichen Inflationsrechner an. Bürger:innen können hier ihre Konsumausgaben, aufgeteilt in verschiedene Güterbereiche, eintragen. Zu den insgesamt 18 Bereichen zählen unter anderem Ausgaben für Miete, Strom, Bekleidung, Nahrungsmittel und Kraftstoffe. Mit diesen Angaben wird die persönliche Inflationsrate ermittelt, indem die Preisentwicklungen der Güterbereiche mit der persönlichen Ausgabenverteilung gewichtet werden. So können interessierte Bürger:innen ihre persönliche mit der amtlichen Inflationsrate vergleichen.

Die Berechnung der persönlichen Inflationsrate erfolgt durch ein einfaches datenbasiertes Verfahren. Dennoch ist das Zustandekommen der persönlichen Inflationsrate und deren Abweichung von der amtlichen Inflationsrate für die meisten Bürger:innen nicht leicht nachvollziehbar. Aus ihrer Sicht ist der Vorgang zur Ermittlung der persönlichen Inflationsrate eine »Black Box«.

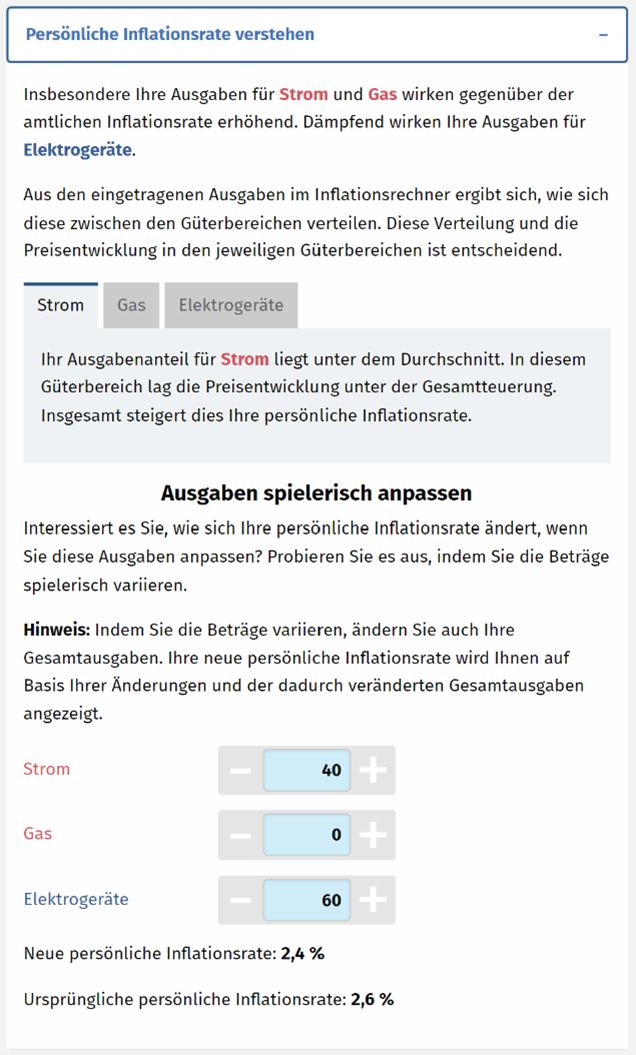

An dieser Stelle setzt das Projekt an: Forscher:innen des XAI-Studios entwickelten in Zusammenarbeit mit Expert:innen des Statistischen Bundesamts ein Erklärmodul, das heute Erklärungen spezifisch für die Zielgruppe des persönlichen Inflationsrechners erzeugt.

Die Zielgruppe des persönlichen Inflationsrechners sind Bürger:innen, die sich unabhängig von ihren Vorkenntnissen über den Einfluss der Inflation auf ihre finanzielle Situation informieren möchten. Für sie sind drei Fragen wichtig:

- Warum weicht die persönliche Inflationsrate von der amtlichen Inflationsrate ab?

- Welche persönlichen Konsumausgaben sind ursächlich für die Abweichung?

- Wie müssten sich die Ausgaben ändern, damit sich die persönliche Inflationsrate ändert?

Die Bürger:innen wollen verstehen, welche der eigenen Konsumausgaben dazu beitragen, dass sich ihre persönliche von der amtlichen Inflationsrate unterscheidet. Das eingesetzte Erklärmodul ermittelt daher, welche Ausgabe-Kategorien einen besonders großen Einfluss auf die Abweichung haben. Für die Erklärungen dieser Abhängigkeiten werden gut verständliche Texte generiert. In einem spielerischen Element können Bürger:innen darauf aufbauend erkunden, wie sich eine Anpassung von Ausgabe-Kategorien auf die persönliche Inflationsrate auswirkt. Ziel der Erklärungen ist unter anderem, das Vertrauen von Bürger:innen in den persönlichen Inflationsrechner und deren Selbstwirksamkeit hinsichtlich der Auswirkungen von Inflation auf die eigene Lebensrealität zu steigern.

Erklärungen schaffen Vertrauen und steigern die Nutzung

Die Wirksamkeit des Erklärmoduls wurde von Forscher:innen des Instituts für Business Analytics der Universität Ulm wissenschaftlich untersucht. Konkret wurde ein randomisiertes Experiment durchgeführt, in dem über 200 Proband:innen entweder den herkömmlichen persönlichen Inflationsrechner oder den neuen persönlichen Inflationsrechner (also inklusive des neuen Erklärmoduls) nutzten und anschließend zu ihren Erfahrungen befragt wurden. Die Ergebnisse demonstrieren den großen Mehrwert von Erklärmodulen für die Bürger:innenzentrierung digitaler Anwendungen.

- Erklärmodule steigern das Vertrauen von Bürger:innen in digitale Anwendungen der öffentlichen Verwaltung

- Erklärmodule erhöhen die Selbstwirksamkeit, das heißt Bürger:innen sind dadurch weniger stark auf weitere Hilfe durch Beschäftigte in der öffentlichen Verwaltung angewiesen

- Erklärmodule fördern die Nutzung digitaler Anwendungen der öffentlichen Verwaltung.

Potenzial von »Erklärbarer KI« für die Digitalisierung der öffentlichen Verwaltung

Das Beispiel des persönlichen Inflationsrechners zeigt, wie bestehende digitale Anwendungen durch die Installation eines Erklärmoduls einen Booster erhalten können. Erklärungen nehmen Bürger:innen bei der Nutzung digitaler Behördenservices »an die Hand«.

»Erklärbare KI«-Ansätze könnten weit über den persönlichen Inflationsrechner hinaus Anwendung finden. Charmant ist bei vielen Ansätzen, dass sie die Funktionstüchtigkeit der zugrundeliegenden datenbasierten Verfahren und Anwendungen nicht beeinträchtigen. So könnten »Erklärbare KI«-Ansätze in Zukunft auch andere Informationsservices von Behörden verbessern, die gegenüber Bürger:innen ihre Prozesse und Leistungen einfach und verständlich kommunizieren wollen. Vielversprechende und noch unerschlossene Anwendungen von »Erklärbarer KI« sind beispielsweise die Kalkulation von Sozialleistungen wie Kindergeld oder die Berechnung der Lohn- und Einkommensteuer.

Weiterführendes von ÖFIT:

Trendthema Erklärbare KI

Berlin, Juli 2019: Dass undurchsichtige Algorithmen zunehmend Empfehlungen für menschliche Entscheider:innen aussprechen oder die Entscheidungen gleich selbst treffen, weckt bei vielen Unbehagen: Wie kann man sicher sein, dass algorithmische Entscheidungen den eigenen Vorstellungen von Fairness und Angemessenheit entsprechen, wenn ihre Entscheidungswege unklar bleiben und sie als Black Box erscheinen? Es gibt also gute Gründe für die Forschung, dass die Entscheidungswege künstlicher Intelligenz (KI) erklärbar werden müssen. Was macht also eine gute Erklärung aus? Und welche technischen Verfahren existieren bereits?

KI im Behördeneinsatz - Erfahrungen und Empfehlungen

Berlin, Dezember 2020: Mit künstlicher Intelligenz (KI) verbinden sich große Erwartungen ebenso wie Skepsis und tiefsitzende Befürchtungen – gerade auch beim Einsatz in der öffentlichen Verwaltung. Um hier die richtigen Rahmenbedingungen zu schaffen, wurden in den letzten Jahren weltweit zahlreiche Leitlinien erarbeitet. Inwiefern werden diese Vorgaben beim KI-Einsatz in der deutschen öffentlichen Verwaltung berücksichtigt? Für die Studie wurden Fallbeispiele aus allen Bereichen der öffentlichen Leistungserbringung auf Bund-, Länder- und Kommunenebene analysiert. Entstanden ist eine systematische Bewertung der KI-Landschaft in der deutschen Verwaltung, die viele praktische Hinweise liefert, wie der KI-Einsatz unter den besonderen Erfordernissen der öffentlichen Verwaltung gelingend gestaltet werden kann./p>

Wegbereiter: Startklar für Low Code

Berlin, 29.07.2024: Der Wegbereiter »Startklar für Low Code« unterstützt dabei, ein kompetentes Low-Code-Team zusammenzustellen und gemeinsam die Anforderungen an die Low-Code-Plattform zu bestimmen.

Veröffentlicht: 13.11.2024